生成AIの付き合い方

最近、慣れていないプログラミング言語で、カンタンなサンプルを書きながら概念実証していくような仕事が多くて、めちゃくちゃ助けられているのがChatGPT。

とくにGPT-4o(Omni)はGPT-4と比べても文脈をよく理解してくれるので、自分くらいの使い方だと、まったくプロンプトエンジニアリングを必要としません。

これからのエンジニアはAIに対して適切なプロンプトを入力することが仕事になるんじゃないか?

なんてことを思った時期もあったのですが、そんな時代は一瞬もなかったし、「プロンプトエンジニア」のような職種も生まれなかった。

で、どんなふうにChatGPTを使っているかというと(生成AIならChatGPTでなくてもなんでも良いのですが)、

- (慣れてないプログラミング言語の)開発環境の構築方法をステップバイステップで解説してほしい。

- (慣れてないプログラミング言語で)「〜」こういうことを実現したい。

- (慣れてないプログラミング言語を示して)「〜」こういうエラーが出た。対処方法は?

- (イマイチなコードを示して)リファクタリングは可能か?

みたいな問いかけをしていけば、あまり躓くことなく、そこそこのレベルで当初の目的を達成できたりします。

もちろん、生成AIの回答がすべて正しいわけではないので、最後の最後では「真偽を見定める感覚」というか、「嗅覚」というようなものは必要だけど、圧倒的に「しょーもないところでハマって1日潰した」みたいなことは減ります。

早めに実証できるところまで動くので、「根っこで間違ってたけどサンクコスト効果でもう後戻りできない」みたいなこともなくなる気がする。なくなってくれ!! 頼む!!

ファクトチェック

あと、生成AIを使って楽をできるのが、たとえば、プレゼン資料の骨子を考えるようなとき。どういうロジックで説明すれば良いか、雛形を生成AIに作ってもらうパターン。

- こういう「〜」を検討しているが、エビデンス付きで効果的に上司に説明するためのプレゼン資料のアジェンダを考えて欲しい。

まぁ、こんな感じのプロンプトでそれっぽいものができると思います。

「エビデンス付きで」のところがミソで、こうやると、それっぽい引用元を示しながら回答してくれるので、それぞれの引用元(分野によってはほとんどが英語)を参照し、確認しながら実際の資料を仕立てていくわけです。

これはこれで、検索窓時代に比べれば十分にステキな体験なのですが、最近知ったGenspark(ジェンスパーク)という生成AI系検索エンジンの、”Genspark Autopilot Agent”という機能がまさにファクトチェックのための機能で、ある意味で衝撃でした。

論より証拠で、先にその生成結果を貼っておきます。

Genspark Autopilot Agentに入力したプロンプト: 地球の温暖化は進んでいる。

最終要約

20の証拠を検討した結果、地球温暖化が進行しているという主張は、複数の信頼できる情報源からのデータによって強く支持されています。海面上昇や平均気温の記録的な高さ、氷河の融解などがその証拠です。これらの現象は、地球温暖化の進行を示す一貫したパターンを形成しており、科学的なコンセンサスとも一致しています。特に、ツバルや世界平均気温のデータは、温暖化の影響が具体的に現れていることを示しています。したがって、地球温暖化が進行しているという主張は、現時点で非常に信頼性が高いと結論付けられます。

Genspark Autopilot Agent

Genspark Autopilot Agentの仕組み

内部の仕組みまでは分かりませんが、

- 人間が入力したプロンプトを適切なプロンプトに分解

- 何らかのフィルタリングをかけた上で、インターネット上からリアルタイムで検索

- 結果をクロスチェック

- 最終的な判断と、その判断に使用したソースを示す

みたいな動きになっていると思います。

「何らかのフィルタリングをかけた上で、インターネット上からリアルタイムで検索」の部分は完全に想像なのですが、プロンプトによっては、例えば当ブログもソースとして示されたので、リアルタイムに検索してるんじゃないかと思います。

クロスチェックするソースの数も多くなるので、非同期で検証処理が動作し、自分が使ってみた範囲では数分で答えが返ってくる感じでした。

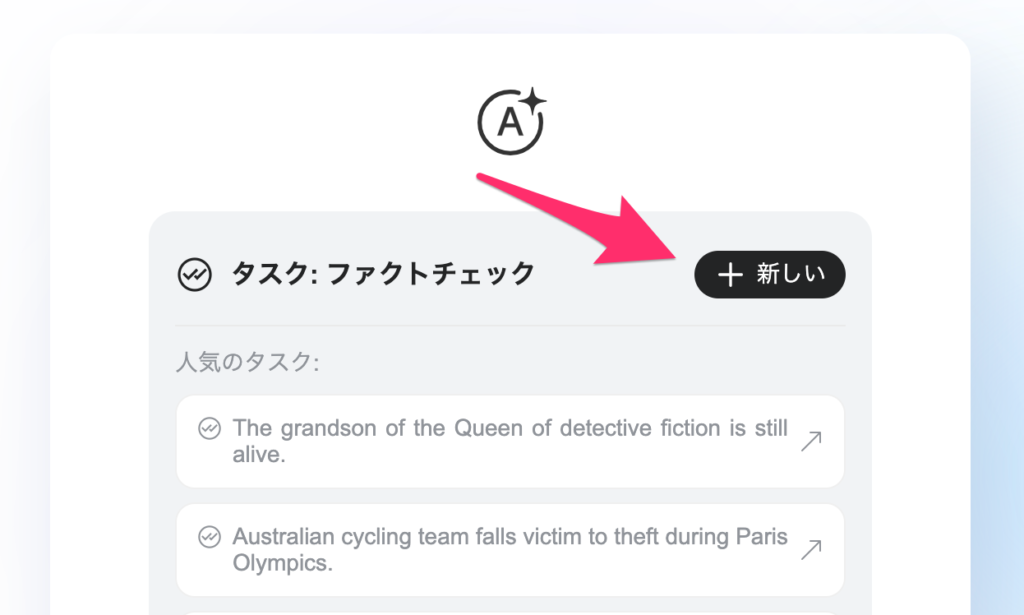

Genspark Autopilot Agentの使い方

www.genspark.ai/autopilotagent

にアクセスして、「+新しい」をクリックします。

MicrosoftかGoogle、あるいはメールアドレスでサインインします。

すでにサインイン済みならこのステップはないはずです。

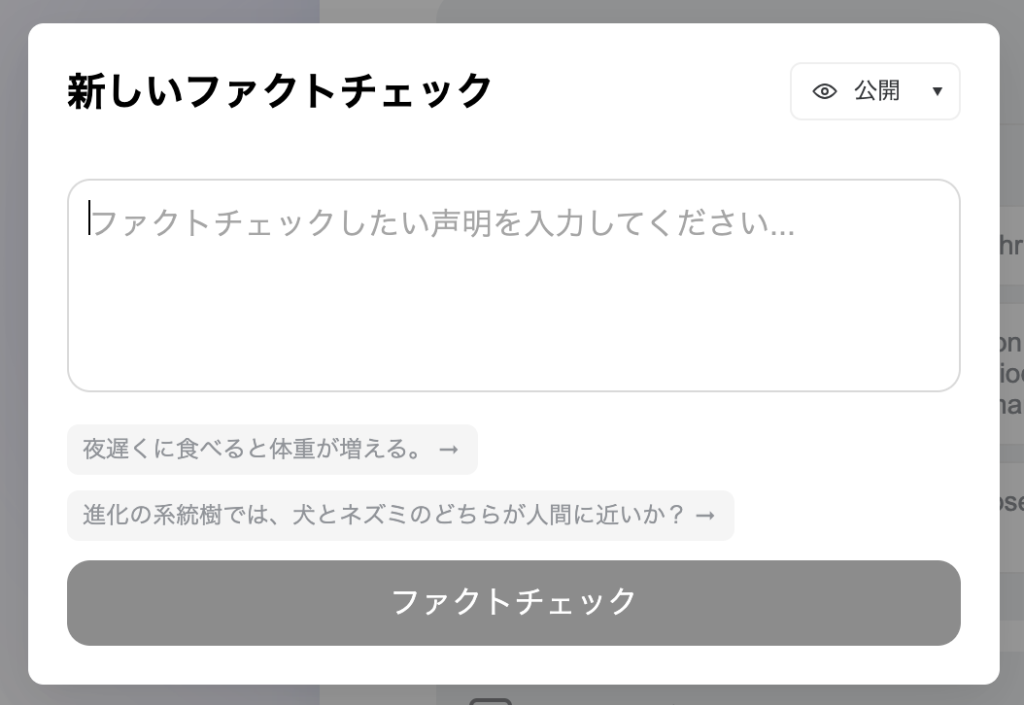

ファクトチェックしたい内容を入力します。

Genspark Autopilot Agentを使う上でのコツ

いくつかファクトチェックをやってみた感じですが、マニアックな内容だと、答えが曖昧になったり、ソースが足りなくて、分かっている人が見ると明らかにおかしな部分を引用したりすることがありました。

ほかの生成AIと同様に、常に「この回答は正しいのだろうか?」という姿勢で臨むのが良さそう。

対策として、例えば、上の「地球の温暖化は進んでいる。」のファクトチェックに対し、「地球の寒冷化が進んでいる。」という真逆の問いかけをしてみるのが良いかも知れません。

この場合、

最終要約

25の情報源を検討した結果、地球の寒冷化が進んでいるという主張は、提供された証拠によって否定されました。多くの証拠が地球温暖化を示しており、特に近年の気温上昇が顕著です。IPCCや科学者のコンセンサスは、温室効果ガスの増加が温暖化の主な原因であるとしています。1970年代に一時的に注目された寒冷化の議論は、その後のデータによって否定されています。したがって、地球の寒冷化が進んでいるという主張は、現在の科学的証拠と矛盾しています。

Genspark Autopilot Agent

という回答になったので、「たしかに温暖化が進んでそうだ」というような結論にはなりそうです。

が、本当にそうだろうか?

Genspark Auto Pilotが合議制でファクトチェックを行っていることを考えれば、「専門家の意見が少数派になる」(それぞれの専門家は全体では少数派のため、多数決を取ると専門領域において少数派になってしまう)という、我々人類がすでに直面している問題を具現している可能性もあります。

あくまでもファクトチェックの手間を減らすツールとして考えて、結果を鵜呑みにしないほうが良さそうです。

「衝撃」の正体

Genspark Auto Pilot。やってることは、生成AIを組み合わせて、ファクトチェックという特定の作業にフォーカスしただけと言えばそれまでで、「衝撃」というほどのことはないかもしれません。

が、たしかに人間がやると手間な作業を、生成AIの得意なタスクに落とし込んで、うまく形にしたなぁという印象で、そういう意味では衝撃を受けたと胸を張りたいところ。

久しぶりに面白いサービスを触った気がしたので、勢いそのままにキーボードを叩いてしまいました。

コメント